语言模型可能发展出对现实的理解以提高其生成能力

让一个像GPT-4这样的大型语言模型(LLM)去闻一个被雨水浸透的露营地的气味,它会礼貌地拒绝。但如果让同样的系统描述这种气味,它会诗意地描绘出“充满期待的空气”和“既清新又泥土味的气味”,尽管它既没有经历过雨,也没有鼻子来帮助它做出这些观察。对此现象的一种可能解释是,LLM只是简单地模仿了其大量训练数据中的文本,而不是在处理对雨或气味的真实理解。

但是,缺乏眼睛是否意味着语言模型永远无法“理解”狮子比家猫“更大”呢?哲学家和科学家们长期以来一直认为,赋予语言意义的能力是人类智能的标志,并思考了赋予我们这种能力的基本要素。

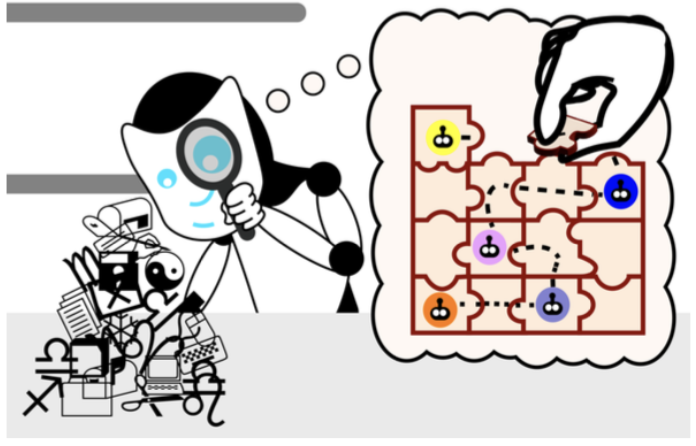

为了解开这个谜团,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员发现了一个有趣的结果,表明语言模型可能会发展出自己对现实的理解,以提高其生成能力。研究团队首先开发了一套小型的Karel谜题,这些谜题包括在模拟环境中为控制机器人编写指令。然后,他们在没有展示这些解决方案如何实际工作的情况下,训练了一个LLM。最后,他们使用一种叫做“探测”的机器学习技术,深入了解了模型在生成新解决方案时的“思维过程”。

在训练了超过100万个随机谜题后,他们发现模型自发地发展出了对基础模拟的概念,尽管在训练过程中从未接触过这种现实。这些发现对我们关于学习语言意义所需的信息类型的直觉提出了质疑,并且表明LLM在未来可能会比今天对语言有更深层次的理解。

探究LLM的思维过程

探测技术帮助查尔斯·金(Charles Jin)亲眼目睹了这一进展。它的作用是解释LLM对指令的理解,揭示了LLM在内部模拟出机器人如何响应每个指令的方式。随着模型解决谜题的能力提高,这些概念也变得更加准确,这表明LLM开始理解这些指令。不久之后,模型开始一致地正确组合各部分以形成有效的指令。

金指出,LLM对语言的理解分阶段发展,就像一个孩子学习语言一样。开始时,它像一个婴儿咿呀学语:重复且大多无法理解。然后,语言模型获得语法知识,即语言的规则。这使得它能够生成看起来像是真实解决方案的指令,但它们仍然不起作用。

然而,LLM的指令会逐渐改善。一旦模型获得了意义,它开始生成正确实现所需规范的指令,就像一个孩子形成连贯的句子一样。

将方法与模型分离:一个“奇异世界”

探测技术的最初目的是“进入LLM的大脑”,正如金所描述的那样,但存在一种可能性,即探测器也为模型进行了一部分思考。研究人员希望确保他们的模型能够独立于探测器理解指令,而不是探测器从LLM的语法掌握中推断出机器人的运动。

“想象一下,你有一堆数据,这些数据编码了语言模型的思维过程,”金建议道。“探测器就像一个法医分析师:你把这堆数据交给分析师,并说,‘这就是机器人如何移动的,现在试着在这堆数据中找到机器人的运动。’分析师稍后告诉你,他们知道在这堆数据中机器人在做什么。但如果这堆数据实际上只是编码了原始指令,而分析师发现了一些聪明的方法来提取指令并据此执行操作呢?那么语言模型实际上并没有真正学会这些指令的意义。”

为了区分他们的角色,研究人员为新的探测器颠倒了指令的含义。在这个“奇异世界”中,正如金所称,诸如“向上”之类的指令现在在指令中意味着“向下”,用于让机器人在其网格上移动。

“如果探测器正在将指令翻译为机器人位置,那么它应该同样能够根据奇异的含义翻译指令,”金说。“但如果探测器实际上是在语言模型的思维过程中找到了原始机器人运动的编码,那么它应该难以从原始思维过程中提取奇异的机器人运动。”

事实证明,新的探测器在翻译中出现了错误,无法解释含义不同的语言模型。这意味着原始语义嵌入在语言模型中,这表明LLM独立于原始探测分类器理解了所需的指令。

“这项研究直接针对现代人工智能中的一个核心问题:大型语言模型的惊人能力是否仅仅归因于大规模的统计相关性,还是大型语言模型发展出了对其所处理现实的有意义的理解?这项研究表明,尽管从未训练过发展这个模型,LLM也发展出了对模拟现实的内部模型,”麻省理工学院电气工程与计算机科学教授、CSAIL成员兼论文高级作者马丁·里纳德(Martin Rinard)说。

这个实验进一步支持了研究团队的分析,即语言模型可以发展出对语言的更深理解。尽管如此,金承认他们的论文还有一些局限性:他们使用了一种非常简单的编程语言和一个相对较小的模型来获得他们的见解。在即将发表的工作中,他们将寻求在更广泛的背景下进行研究。虽然金的最新研究没有概述如何更快地让语言模型学习意义,但他相信未来的工作可以基于这些见解来改进语言模型的训练。

“一个令人着迷的未解之谜是LLM是否实际上在使用其内部的现实模型来推理现实世界,并解决机器人导航问题,”里纳德说。“尽管我们的结果与LLM以这种方式使用模型一致,但我们的实验并未设计成回答这个后续问题。”

LLM未知的未来

这个实验进一步支持了研究团队的分析,即语言模型可以发展出对语言的更深理解。尽管如此,金承认他们的论文还有一些局限性:他们使用了一种非常简单的编程语言和一个相对较小的模型来获得他们的见解。在即将发表的工作中,他们将寻求在更广泛的背景下进行研究。虽然金的最新研究没有概述如何更快地让语言模型学习意义,但他相信未来的工作可以基于这些见解来改进语言模型的训练。

“一个令人着迷的未解之谜是LLM是否实际上在使用其内部的现实模型来推理现实世界,并解决机器人导航问题,”里纳德说。“尽管我们的结果与LLM以这种方式使用模型一致,但我们的实验并未设计成回答这个后续问题。”